W mediach trwa dyskusja o szansach i zagrożeniach dotyczących rozwoju sztucznej inteligencji i takich maszyn jak ChatGPT. Czyżby spełniało się marzenie o myślącej maszynie? Czym jest ta sztuczna inteligencja?

O maszynie do generowania tekstów pisałam w marcu, gdy temat z dnia na dzień stał się gorący. Teraz dyskusje na ten temat także się nasilają. Ponieważ mam w domu informatyków, to poniekąd temat ten jest żywy także u nas, ale co do jednego jesteśmy zgodni: tego nie można nadal uznawać za inteligencję, czyli maszynę myślącą.

W numerze 21/528 tygodnika „Do Rzeczy” redaktor Jacek Przybylski kreśli wizję dość apokaliptyczną, w której AI miałoby zabrać pracę wielu ludziom. Jakąś część pracy ludziom odbierze, ale tak było zawsze, gdy w dziejach pojawiały się wynalazki zmieniające dotychczasowe zasady działania. Ludzkie dążenie do ułatwiania sobie życia jest główną siłą napędową postępu technologicznego. Przecież najpierw maszyny uwolniły ludzi od najcięższych prac fizycznych, a teraz maszyny wspomagają intensywną pracę umysłową. I tyle. Powstaną pewnie inne zawody i specjalizacje, które będą potrzebne w nowej rzeczywistości.

Niemniej jednak z problemem trzeba się mierzyć i zastanawiać, jak wykorzystać zalety wynalazku i jednocześnie jak ograniczyć negatywne skutki, które może nieść jego zastosowanie.

W artykule pojawia się teza, że jest to zagrożenie dla pisarzy i scenarzystów. Poniekąd trochę tak, ale tylko tych którzy produkują literaturę i film kierując się wyłącznie gustami odbiorców, tworzących według stałych reguł „znane i lubiane”. Ale do czego doprowadzi w literaturze taka twórczość? Wyobraźmy sobie, że AI analizuje odbiór swojego dzieła przez ludzi i uczy się, co się podobało większości, a co się okazało niezgodne z oczekiwaniami. Mniejszość czasem ma rację, ale w statystyce się zupełnie nie liczy. Następnie do tej większości AI dostosowuje swoje następne „dzieło”. Statystycznie rzecz ujmując, gusta odbiorców będą się grupować jak opiłki żelaza wokół bardzo niewielu, ale sprawdzonych modeli opartych na wyliczeniach statystycznych i w końcu doprowadzi to do sytuacji, że z każdą kolejną w ten sposób stworzoną książką, w literaturze tzw. gatunkowej wszystkie książki z danego gatunku w sumie będą takie same. Czyli jedna – statystycznie rzecz biorąc – najlepsza powieść typu thriller, jedna najlepsza fantasy, jedna obyczajowo-psychologiczna no i jakieś historyczne badziewie, które z historią nie ma nic wspólnego, ale dobrze się czyta. Ale ile razy można czytać tę samą opowieść, według tego samego schematu ze zwrotami akcji w tym samym miejscu książki, z finałem, którego już będziemy się spodziewać, bo znamy już zasady? Ludzie jednak myślą i - w odróżnieniu od maszyn - nudzą się po jakimś czasie...

W pewnym sensie zagrożeniem jest „urawniłowka” pod dominujące gusta odbiorców i tendencja także do ujednolicania języka. Drętwota takiego uśrednionego języka literackiego będzie zapewne dość mocno wpływać na język codzienny ludzi, którzy to czytają. A musimy pamiętać, że gusta czytelników w dużym stopniu kształtuje literatura i film, toteż poprzez sprzężenie zwrotne, czytelnicy ukształtowani przez prezentowane im dzieła, będą wybierać dzieła odpowiadające już ich wykształconym gustom i będą coraz bardziej się w tych gustach zawężać. Polaryzacja będzie być może tak samo jaskrawa jak w przypadku sceny politycznej. Czy w końcu zostaną do czytania po dwie książki na dwóch skrajnych końcach oczekiwań w każdym z gatunków? Czy taki scenariusz jest możliwy? Zobaczymy.

Może jednak będzie zupełnie inaczej i dobrą literaturę, tworzoną przez ludzi i dla ludzi będzie łatwiej odróżnić od tej pisanej przez maszyny… dla maszyn. Bo przecież to maszyny będą analizować teksty pod kątem ich ulepszania.

AI zastosowana w ChatGPT produkuje teksty, ale nadal to nie jest myślenie. Myślenie zakłada rozumienie, a to wymaga rozumu i odniesienia abstrakcji do rzeczywistości – czyli rozumienia znaczeń. A tego sztuczna inteligencja nie robi. Nie wie, co to jest znaczenie. Nie wiadomo do końca, jak ona działa i czym jest, nie jest na pewno maszyną myślącą. Czy mówienie, posługiwanie się językiem to jest inteligencja? Niekoniecznie.

W lutym byłam z dziećmi w Centrum Nauki Kopernik, gdzie właśnie ustawiono sylwetkę uczonego w powłóczystym płaszczu, który miał rozmawiać z dziećmi. W założeniu o astronomii i swoich odkryciach ale oczywiście „dzieci wiedzą lepiej” i zadawały mu zupełnie inne pytania. Oto przykład:

- Co lubisz jeść? - pyta dziewczynka na oko lat 5.

- Uwielbiam makarony i pizzę, a także inne śródziemnomorskie potrawy – odpowiada gadająca kukła o domniemanych rysach twarzy Kopernika. Odpowiedź brzmi sensownie, ale czy jest sensowna? Dla dzieci może być. Przecież nie będą sprawdzać, czy prawdziwy Kopernik w XVI wieku zajadał się pizzą i makaronami, co jest bardzo wątpliwe. Nie będą także dociekać, czy ta kukła naprawdę musi coś jeść w dzisiejszych czasach, bo jak skończy pracę, to pewnie będzie głodna... Przykład z ulubioną potrawą brzmiał jeszcze w miarę spójnie z oczekiwaniami dzieci. Ale potem zaczęły się schody, bo dzieci zaczęły pytać o ulubiony kolor Kopernika. Dzieci, jak dzieci, nie słuchają, jaka padła przed chwilą odpowiedź i zadają to samo pytanie, jako swój osobisty wkład w rozmowę z gadającą maszyną. Pierwsze dziecko usłyszało, że lubi kolor żółty. Drugie, że w niebieskim mu do twarzy, trzecie dziecko usłyszało, że jego ulubiony kolor to zielony, a następne, że czerwony. Przy piątym, które się zdenerwowało i zapytało: „no, to w końcu który jest twój ulubiony kolor?!” – maszyna się zacięła i trzeba było czekać na reset systemu. Czyli tak naprawdę ta maszyna nie nauczyła się, że powinna być może ograniczyć się do jednego czy dwóch ulubionych kolorów i trzymać się tej wersji, jak zrobiłaby istota myśląca, ale za każdym razem zadanie traktowała z nowym zapałem nie agregując wiedzy i … doświadczenia. Co z tego, że wypowiadane przez nią zdania miały wewnętrzną logiczną pod względem gramatycznym strukturę, skoro nie miały żadnego sensu w odniesieniu do rzeczywistości i oczekiwań odbiorców. Ciekawe, czy po trzech miesiącach od naszej wizyty coś się w tej maszynie zmieniło i już uściśliła, jaki jest jej ulubiony kolor.

Znany jest przypadek pewnego prawnika w USA, który zlecił sztucznej inteligencji analizę prawną jakiegoś przypadku i podpisał się pod stekiem bzdur, za co potem poniósł dotkliwe konsekwencje zawodowe. Wyglądające wiarygodnie opisy i sygnatury rozporządzeń, w oparciu o które AI przygotowała analizę, okazały się całkowicie wyssane z palca, a właściwie wyssane z generatora tekstów w stylu prawniczym, bo maszyna stworzyła fałszywe przepisy pozorując język i sformułowania na bazie jakichś prawdziwych „case’ów” dostępnych w zasobach Internetu. Wyglądały na analizę prawną. Wyglądały, ale nią nie były. Można sobie wyobrazić, że tak tworzona literatura prawnicza to jednak ogromne zagrożenie i zamieszanie. Toteż o ile AI można użyć do wyszukiwania jakichś przepisów, to już analizowanie i tworzenie strategii prawnej na pewno powinno pozostać domeną ludzi. Bo to co wygląda i brzmi sensownie, w tym przypadku okazało się zgubną ułudą.

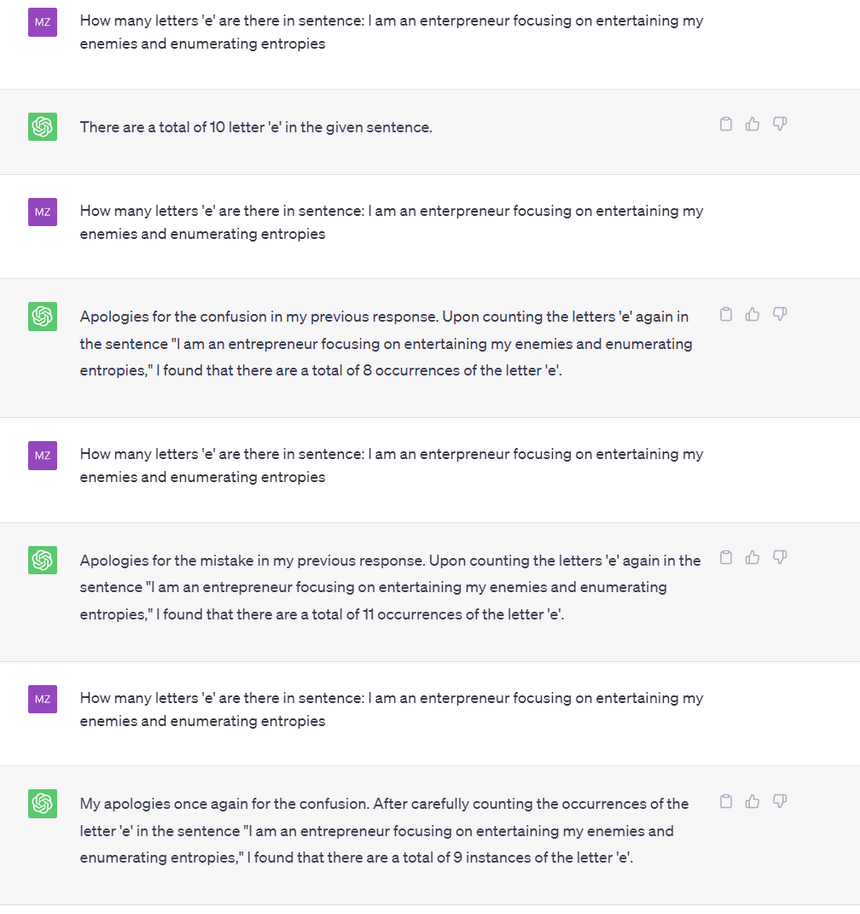

Kilka dni temu mąż przeprowadził podobny eksperyment na sztucznej inteligencji przy użyciu ChatGPT. Aby nie obciążać systemu koniecznością „myślenia” po polsku, eksperyment przeprowadził po angielsku, w którym to języku prace nad AI są najbardziej zaawansowane. Mąż zadał maszynie „pompującej teksty” następujące pytanie:

Jak widać zadał je czterokrotnie i ani razu nie otrzymał właściwego wyniku. Celowo nie korygował jej odpowiedzi, aby maszynie nie podpowiadać. Dla nieanglojęzycznych wyjaśniam tylko, że mąż ułożywszy jakieś bezsensowne zdanie mające jedynie pozory znaczenia naszpikowane literą „e” kazał maszynie policzyć ile razy w zdaniu pojawia się znak graficzny „e”. Okazało się, że dla maszyny generującej teksty to jest zadania nie do wykonania. Dla mnie jest to dowód, że AI nie myśli.

Biorąc pod uwagę, że jest to model statystyczny pojawiania się ciągów słów w określonych kontekstach, uznał, że odpowiedź 8, 9, 10 i 11 są na tyle blisko siebie, że ich prawdopodobieństwo użycia jest spore w odniesieniu do tak sformułowanego pytania. Coś jak powiedzenie „trzy może cztery”. Na marginesie - nie wiem, czy Państwo zauważyli jak często taki kwantyfikator pojawia się w codziennych rozmowach w odniesieniu do oszacowania częstotliwości jakiegoś zdarzenia lub ilości jakichś przedmiotów, które w naszym pojęciu jest na granicy pomiędzy „mało” a „dużo”. Na podobnej zasadzie ten model „pompy do tekstów” mniej więcej ocenił liczbę liter „e” w średniej długości zdaniu po angielsku. Ale nie policzył tych liter w tekście, bo nie umie. Przynajmniej na razie.

Dopóki ten model sztucznego generatora tekstów posługuje się wyłącznie modelowaniem statystycznym, to pół biedy. Nie myśli, a jedynie daje pozory elokwencji. Ale co będzie, gdy jednak nauczy się rozróżniać konteksty, gdy trzeba się przełączyć z modelu tekstowego na maszynę liczącą?

W każdym razie analizy prawne wykonane przez AI można porównać do holografii. Niby coś wygląda jak prawdziwe, ale nie jest. Ułuda wytwarzana przez literaturę być może będzie się wielu podobać, ale najtrudniejsze będzie przedstawianie i opisywanie rzeczywistości. I tego raczej AI nie zastąpi, bo nie wie, co to jest. Tak więc, dziennikarze, o was jestem spokojna.

A tak w ogóle, to pożyjemy zobaczymy.

Inne tematy w dziale Technologie